Poté, co OpenAI nedávno oznámila, že weboví administrátoři budou moci zablokovat její systémy v procházení jejich obsahu, prostřednictvím aktualizace souboru robots.txt jejich webu, se také Google snaží dát webovým administrátorům větší kontrolu nad jejich daty a tím, zda povolí jejich scrapery pro generativní AI vyhledávání.

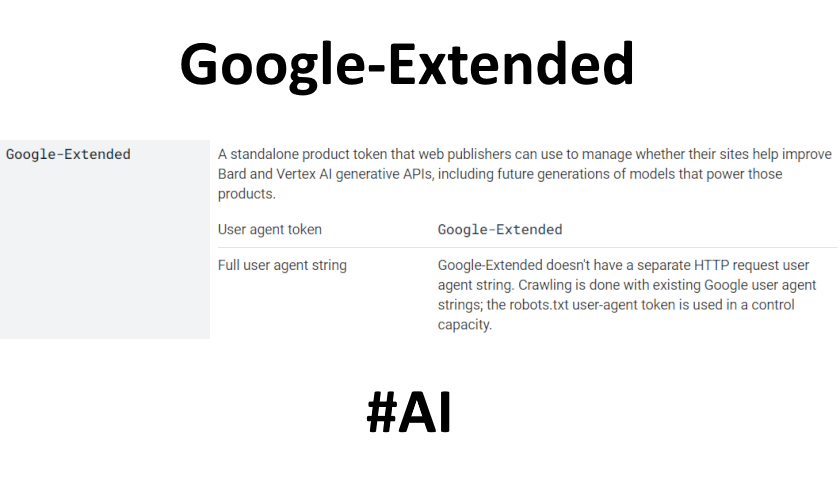

Jak vysvětlil Google:

„Dnes představujeme Google-Extended, nový ovládací prvek, který mohou weboví vydavatelé používat ke správě toho, zda jejich weby pomohou zlepšovat generativní API Bard a Vertex AI, včetně budoucích generací modelů, které tyto produkty pohánějí. Pomocí Google-Extended k řízení přístupu k obsahu na webu si správce webu může vybrat, zda pomůže těmto modelům umělé inteligence, aby se postupem času staly přesnějšími a schopnějšími.“

Což je podobné formulaci, kterou OpenAI použila ve snaze získat více webů, které umožní přístup k datům s příslibem vylepšení svých modelů.

Dokumentace OpenAI skutečně vysvětluje, že:

„Načtený obsah se používá pouze v tréninkovém procesu k tomu, abychom naučili naše modely, jak reagovat na požadavek uživatele vzhledem k tomuto obsahu (tj. zlepšit naše modely při procházení), nikoli proto, aby naše modely vylepšovaly vytváření odpovědí.“

Je zřejmé, že jak Google, tak OpenAI chtějí i nadále přinášet co nejvíce dat z internetu. Schopnosti blokovat modely umělé inteligence před obsahem však již využilo mnoho velkých vydavatelů a tvůrců, kteří tak činí jako prostředek k ochraně autorských práv a zastavení generativních systémů umělé inteligence v replikaci jejich práce.

Pro některé je samozřejmě příliš pozdě, protože například OpenAI již staví své modely GPT (až GPT-4) na základě dat získaných z webu před rokem 2021. Některé velké jazykové modely (LLM) tedy byly vytvořeny dříve než tato oprávnění byla zveřejněna.

Zdroj: socialmediatoday.com